动画讲解 Mamba 状态空间模型_哔哩哔哩_bilibili

旧文本向量乘权重加残差 感觉好像transformer

过个llm head输出y

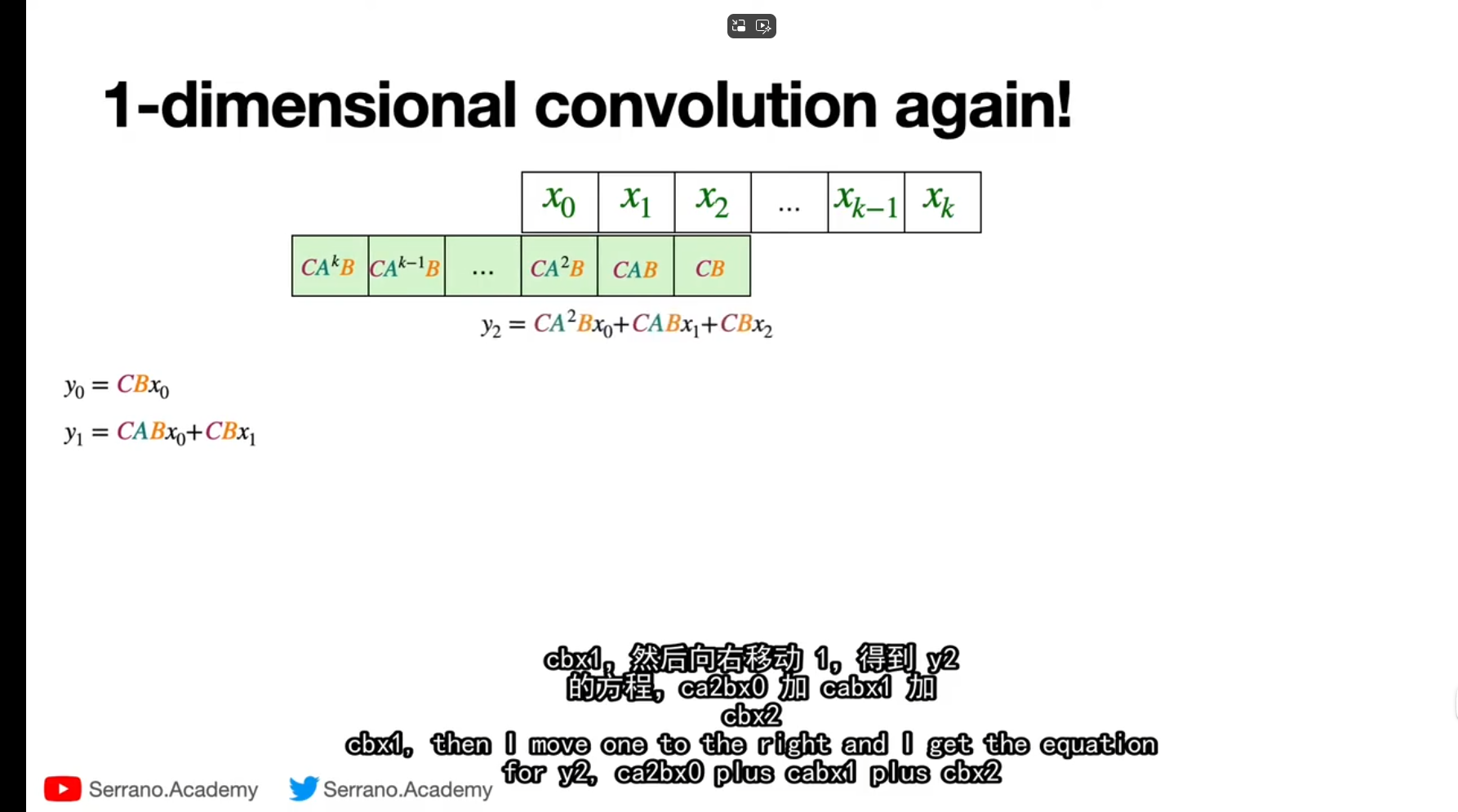

卷积真的很快

参考一文通透想颠覆Transformer的Mamba:从SSM、HiPPO、S4到Mamba(被誉为Mamba最佳解读)_mamba模型-CSDN博客

偷了

Transformer的二次复杂度哪来的

为什么rnn会忘记一部分信息,mamba不会

mamba的A,B,C矩阵是独立于文本存在的吗

参考【官方Mamba库】原理简述和代码解析_mamba模型代码-CSDN博客

mamba没有rnn的tanh激活函数怎么实现非线性化的

)

^ 3 − x ^ 2 * y ^ 3 = 1)

![[Unity]-[UI]-[Image] 关于UI精灵图资源导入设置的详细解释](http://pic.xiahunao.cn/[Unity]-[UI]-[Image] 关于UI精灵图资源导入设置的详细解释)