前言:

在人工智能领域,视觉语言模型的竞争愈发激烈。GPT-4o 一直是该领域的佼佼者,但英伟达的 Eagle 2.5 横空出世,凭借其 80 亿参数的精简架构,在长上下文多模态任务中表现出色,尤其是在视频和高分辨率图像理解方面。其创新的训练策略和优化架构使其成为 GPT-4o 的有力竞争者,有望重塑视觉 AI 的行业标准。这场技术对决表明,人工智能的未来不仅在于规模,更在于设

Eagle 2.5 专注于处理大规模视频和图像,尤其在高分辨率图像和长视频序列方面表现出色。尽管其参数规模仅为 8B,但在 Video-MME 基准测试(512 帧输入)中,它取得了 72.4% 的高分,与 Qwen2.5-VL-72B 和 InternVL2.5-78B 等更大规模的模型不相上下。

1.从训练方法看 Eagle 2.5

Eagle 2.5 的卓越表现得益于两项关键训练策略:信息优先采样(Information-First Sampling) 和 渐进式后训练(Progressive Post-Training) 。这些创新方法显著提升了模型在视觉与语言任务中的性能。

信息优先采样:优化输入质量的关键

信息优先采样通过两项核心技术实现了对视觉和文本输入的精细化处理:

- 图像区域保留(IAP) :该技术能够智能地保留超过 60% 的原始图像区域,同时有效减少宽高比失真,确保图像的关键细节得以完整保留。

- 自动降级采样(ADS) :根据上下文长度动态调整视觉与文本输入的比例,在保证文本完整性的同时,优化视觉细节的表现,使模型能够更好地平衡多模态输入。

渐进式后训练:扩展上下文适应能力

渐进式后训练是一种逐步扩展模型上下文窗口的训练方法,从初始的 32K token 扩展到最终的 128K token。这种渐进式的训练方式使模型能够在不同长度的输入中保持稳定的性能,避免了因过拟合单一上下文范围而导致的性能瓶颈。

多模态架构的协同支持

为了进一步增强模型的灵活性和适应性,Eagle 2.5 还结合了 SigLIP 视觉编码器 和 MLP 投影层 。这些组件共同作用,确保模型在多样化任务中表现出色,无论是复杂的视觉理解还是跨模态生成任务,都能游刃有余。

2.预训练定制数据集

Eagle 2.5 的训练数据管道整合了开源资源和专为长视频理解设计的定制数据集 Eagle-Video-110K,并采用了双重标注方式。

在自上而下的方法中,通过故事级分割结合人类标注的章节元数据和 GPT-4 生成的密集描述来标注数据;而在自下而上的方法中,则利用 GPT-4o 为短片段生成问答对,以捕捉时空细节。

数据集通过余弦相似度筛选,注重多样性而非冗余,确保叙事连贯性和细粒度标注,从而显著提升了模型在高帧数(≥128帧)任务中的表现。

3.性能表现

Eagle 2.5-8B 在视频和图像理解的多项任务中表现优异。在视频基准测试中,其 MVBench 得分为 74.8,MLVU 为 77.6,LongVideoBench 为 66.4;在图像基准测试中,DocVQA 得分为 94.1,ChartQA 为 87.5,InfoVQA 为 80.4。

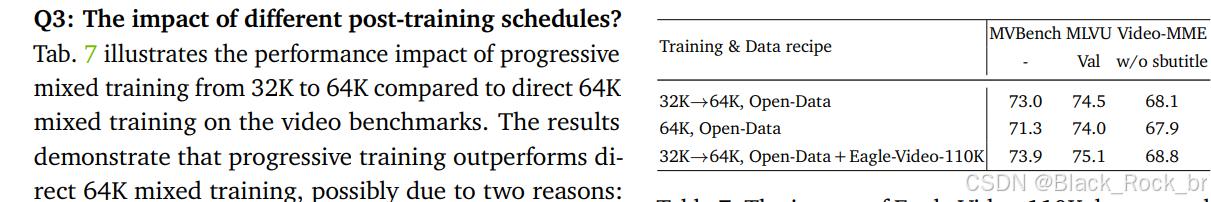

消融研究表明,移除 IAP 和 ADS 会导致性能下降,而加入渐进式训练和 Eagle-Video-110K 数据集则能带来更稳定的性能提升。

未来展望

Eagle 2.5 的推出不仅标志着英伟达在多模态学习领域的突破,也为整个人工智能行业树立了新的标杆。其高效的参数规模和卓越的性能使其在资源受限的环境中更具优势,适用于医疗影像分析、自动驾驶辅助系统、虚拟助手开发等多个领域。随着硬件进步和跨学科合作的深化,Eagle 2.5 所代表的多模态学习方向将引领行业迈向更高效率和更广泛应用的新阶段。

综上所述,Eagle 2.5 以其创新的训练策略、优化的数据集设计和卓越的性能表现,成功地在视觉语言模型领域与 GPT-4o 展开了竞争,为未来的人工智能发展提供了新的方向和思路。

link:https://arxiv.org/pdf/2504.15271

)

)