任务场景

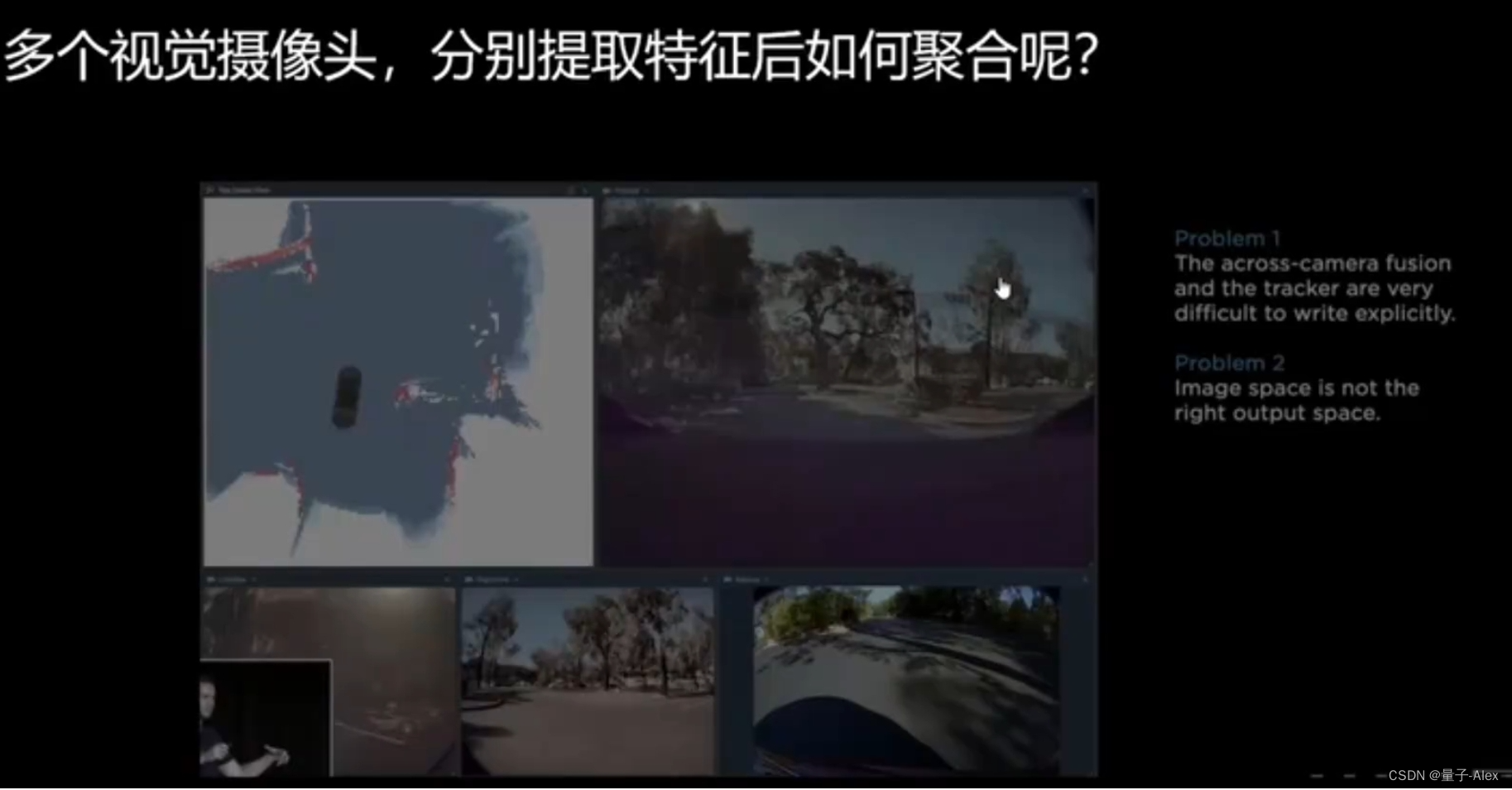

多模态融合和多传感器融合

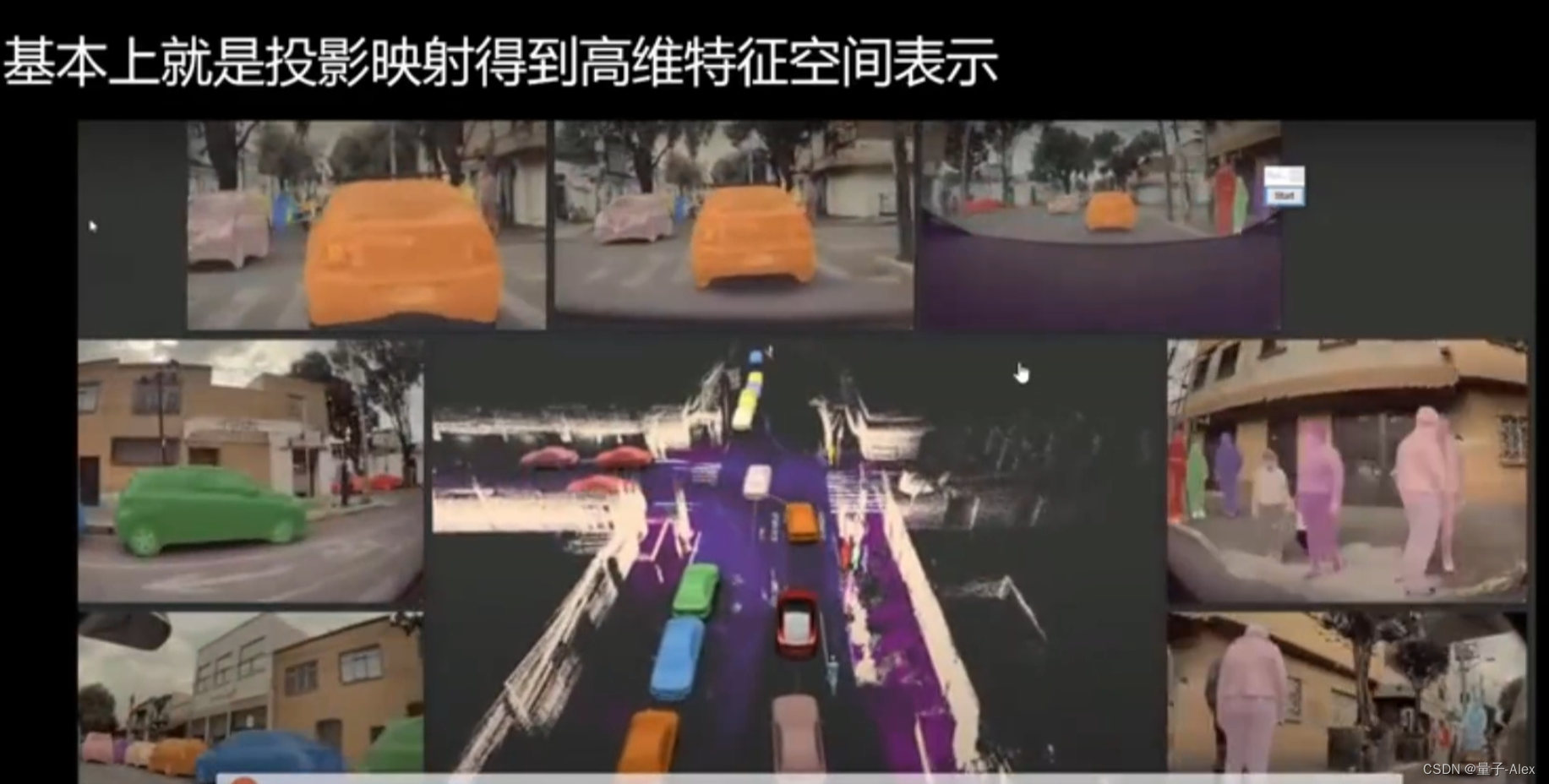

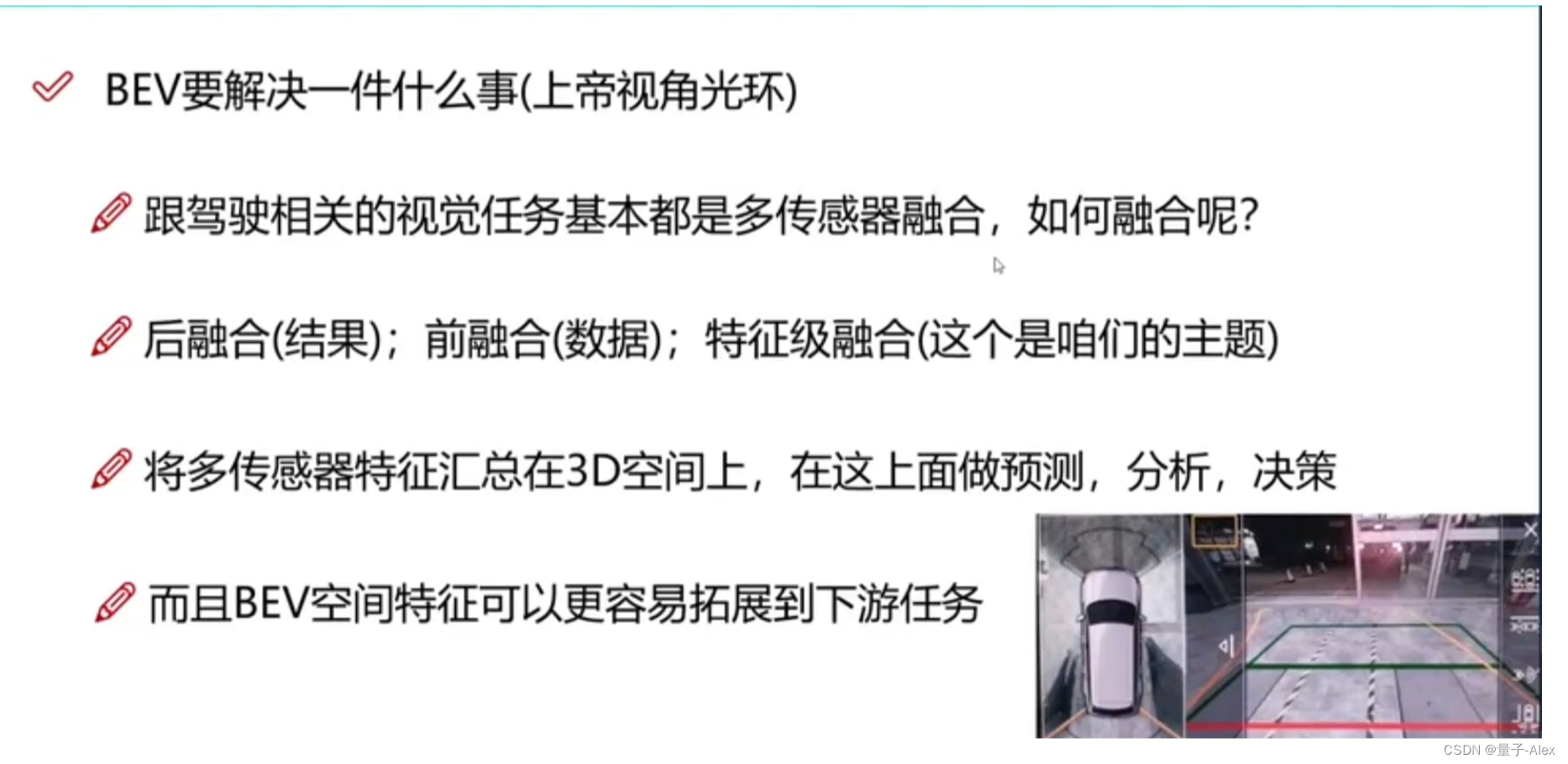

BEV:鸟瞰图

这个特征空间与每个视角都相关

早期是用后融合,目前比较流行的是特征级融合

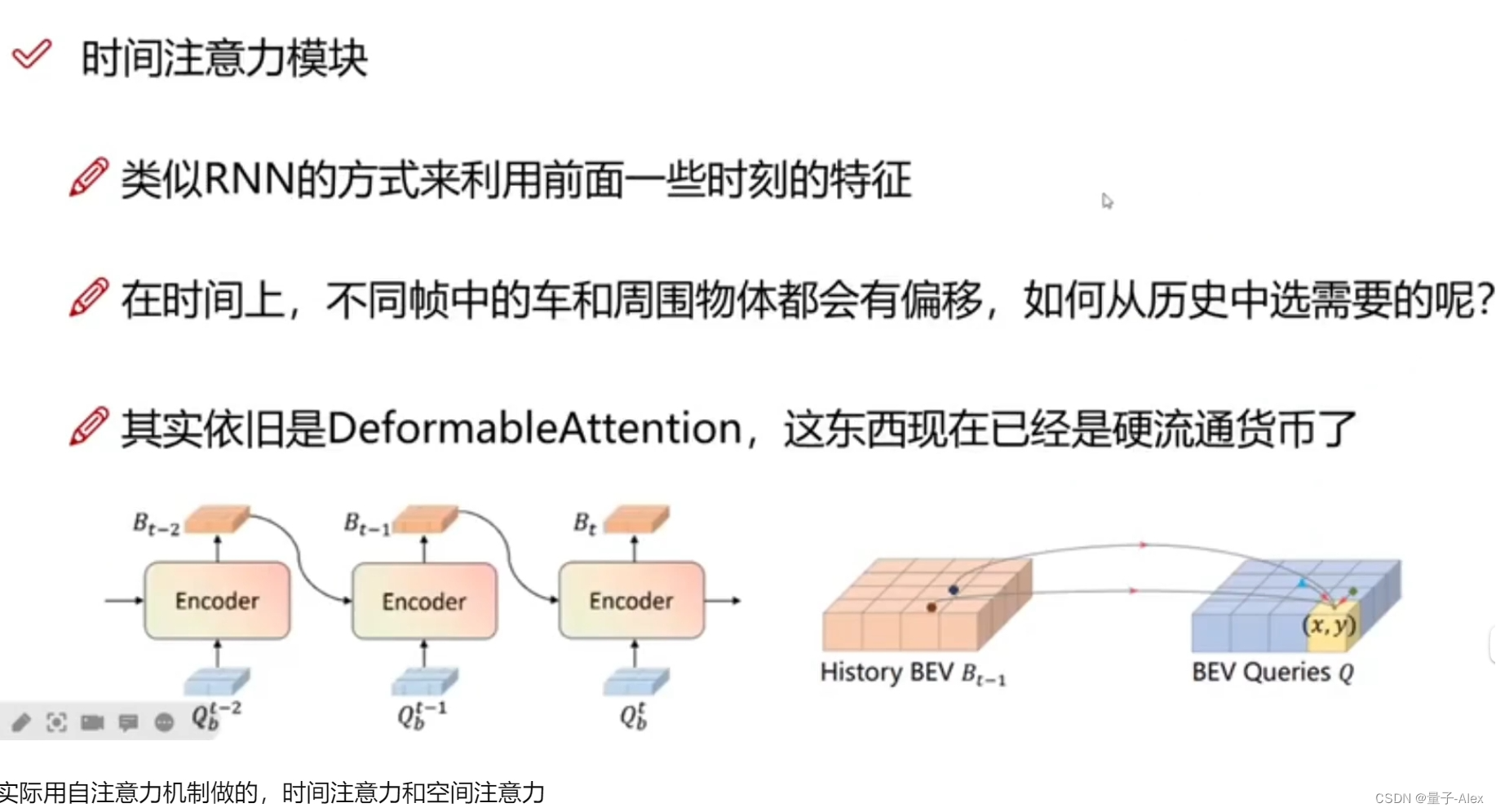

自身运动补偿:如果按照像素点进行特征对齐,需要指定偏移量 x y两个方向

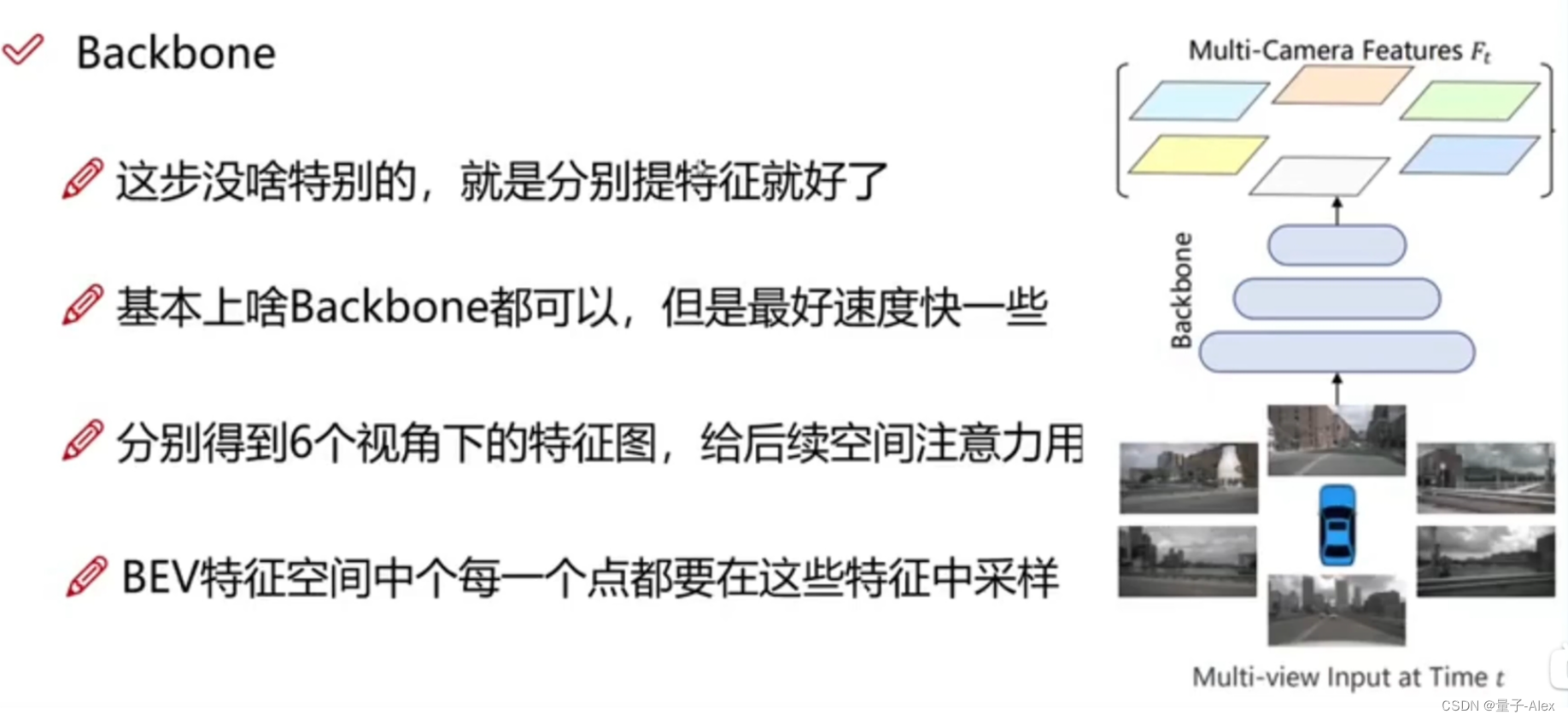

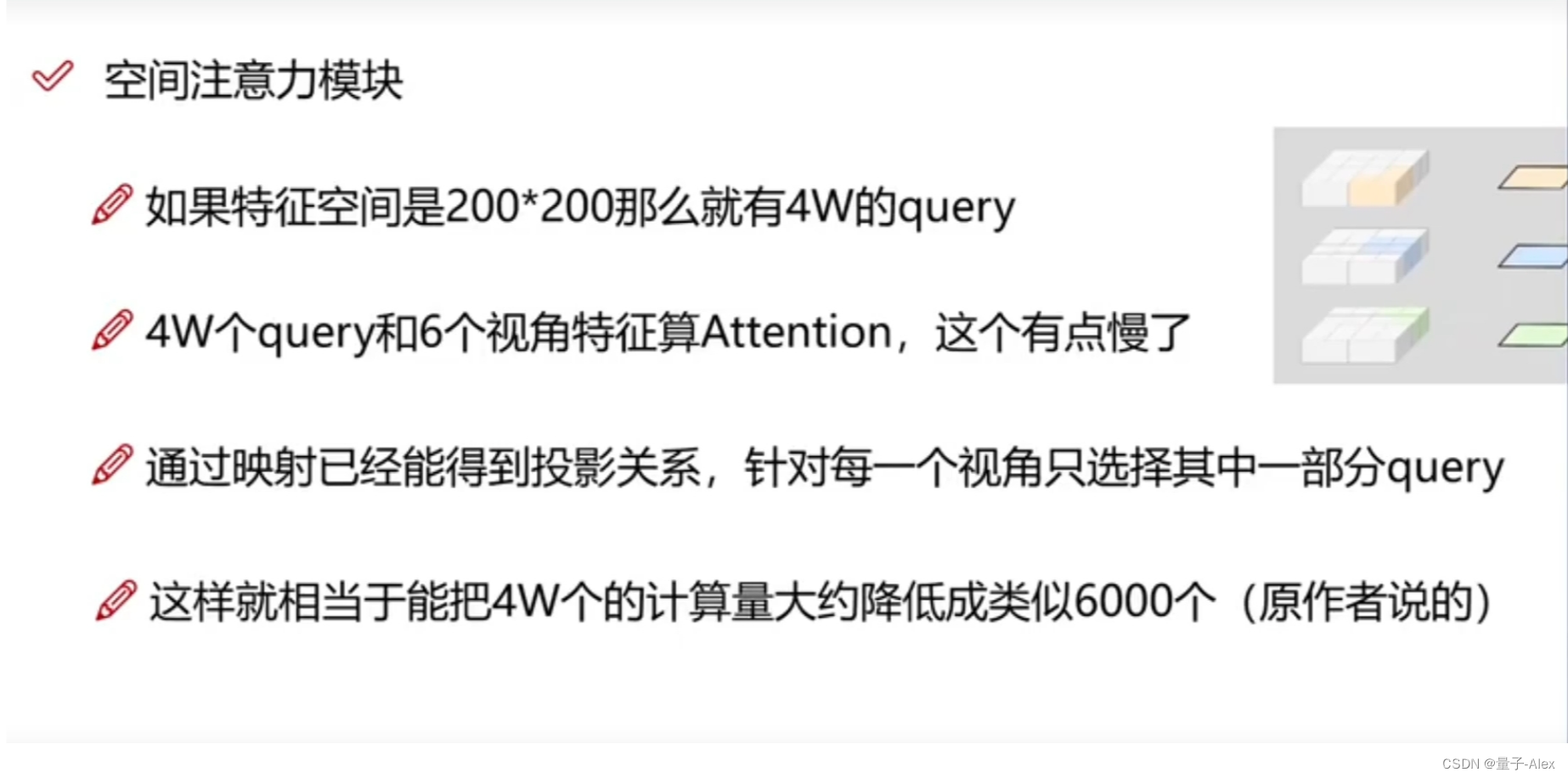

特征空间是自己定义的,常见的是200x200,根据自己的硬件成本去考虑,每个网格点是一个特征向量,

同一个特征空间同时做多个下游任务,每一个相机视图又有多个特征,

分辨率太高,导致计算成本过高,难以训练

BEVFormer

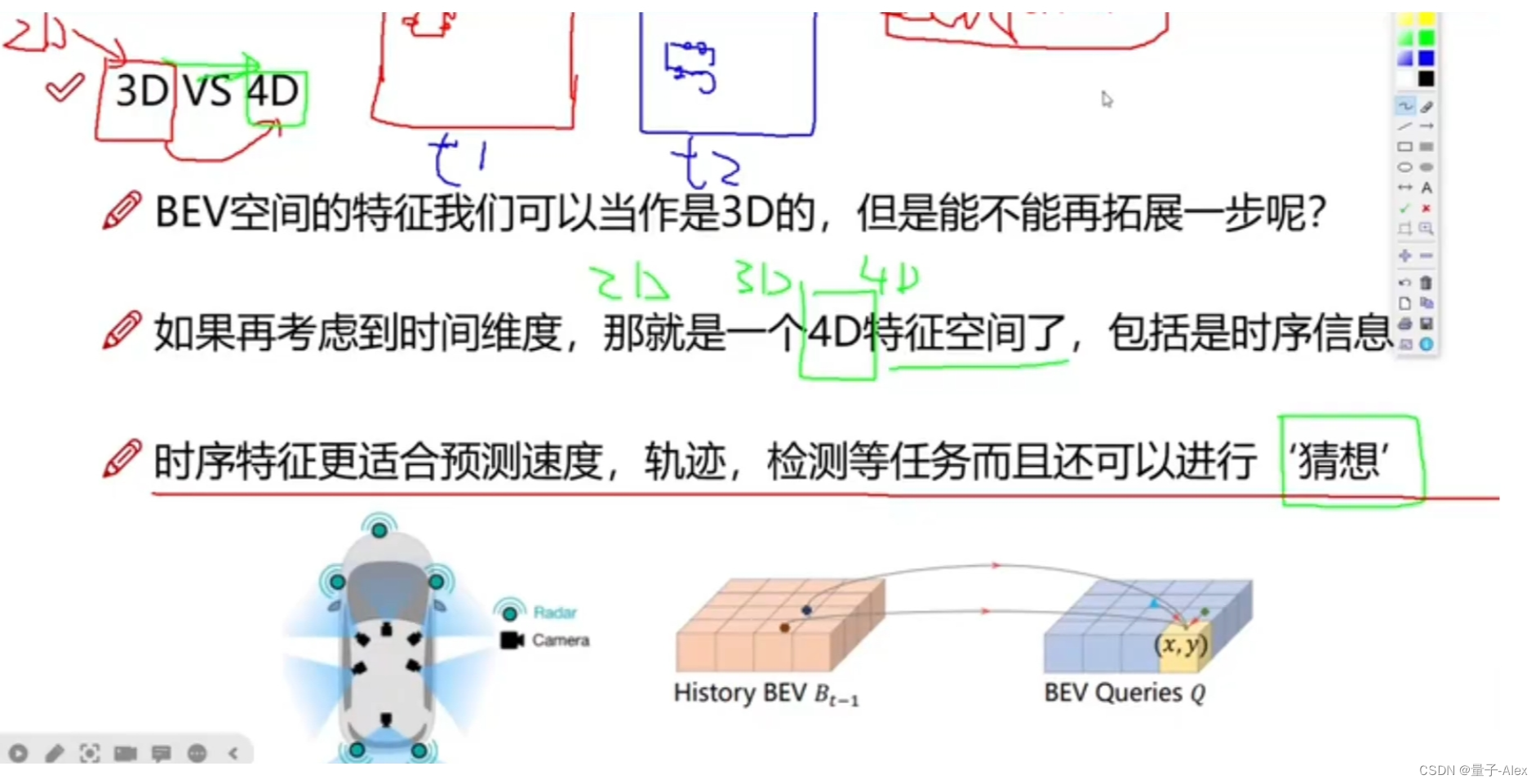

时间和空间上都要做对齐,

DeformableAttention是目前的主流

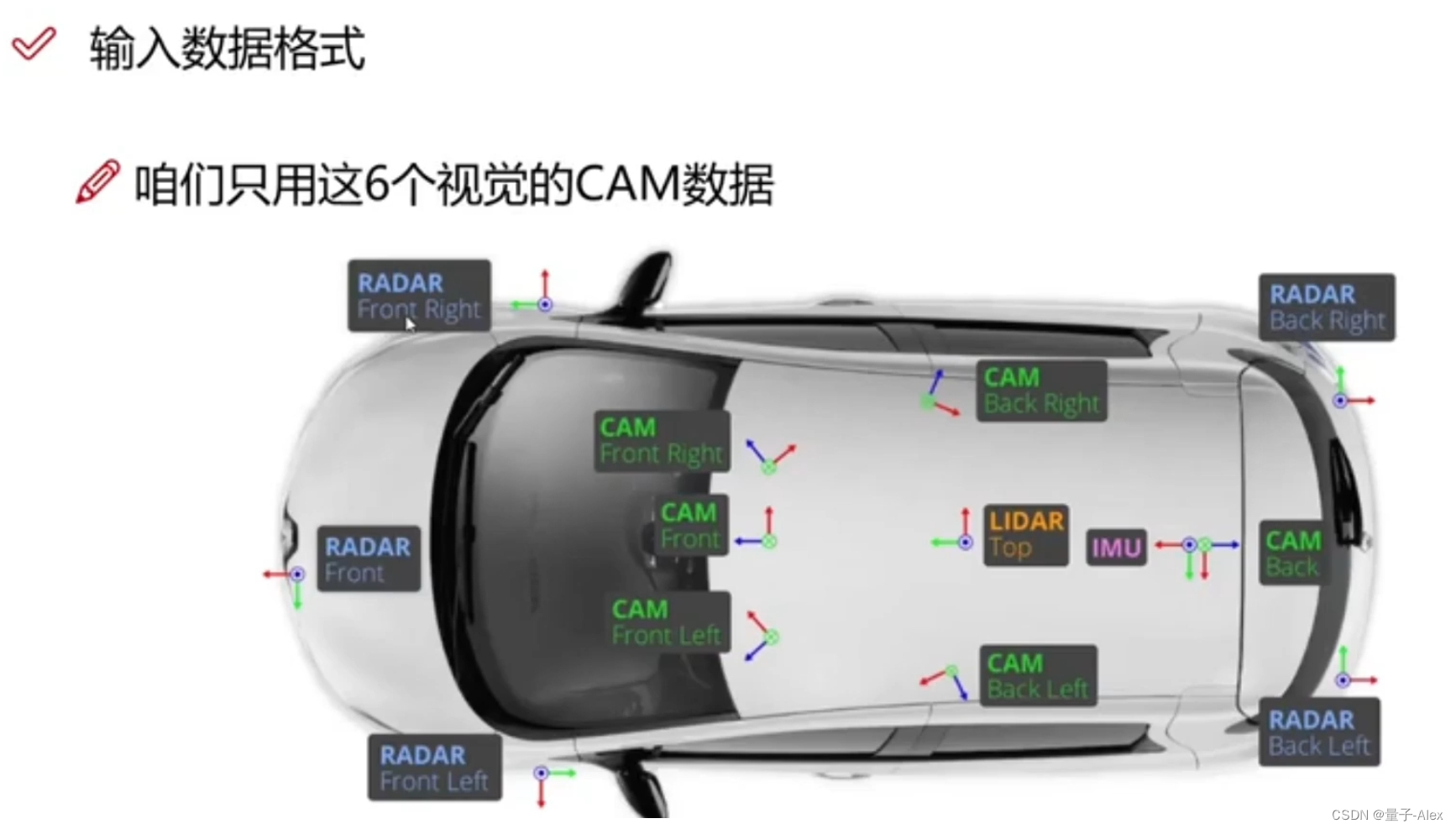

输入

输入是一个序列

batch_size = 16

queue=3 t-2 t-1 t 不仅要考虑当前时刻,还要考虑前两个时刻,t-2 t-1

cam=6 6个摄像头

C=RGB 3

H W 高 宽

只用6个视角的摄像头

Backbone 是什么都可以 最好要速度快

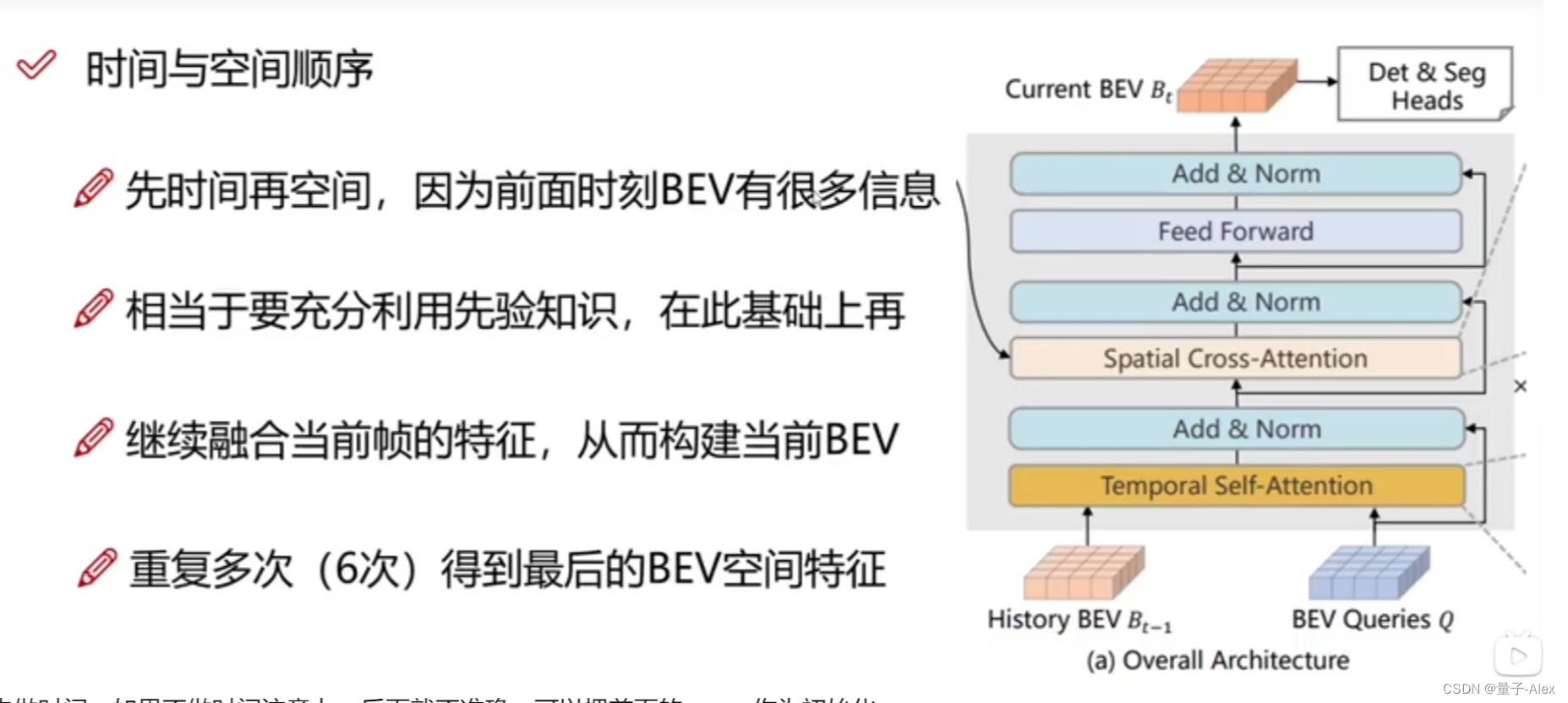

实际用自注意力机制做的,时间注意力和空间注意力

实际用自注意力机制做的,时间注意力和空间注意力

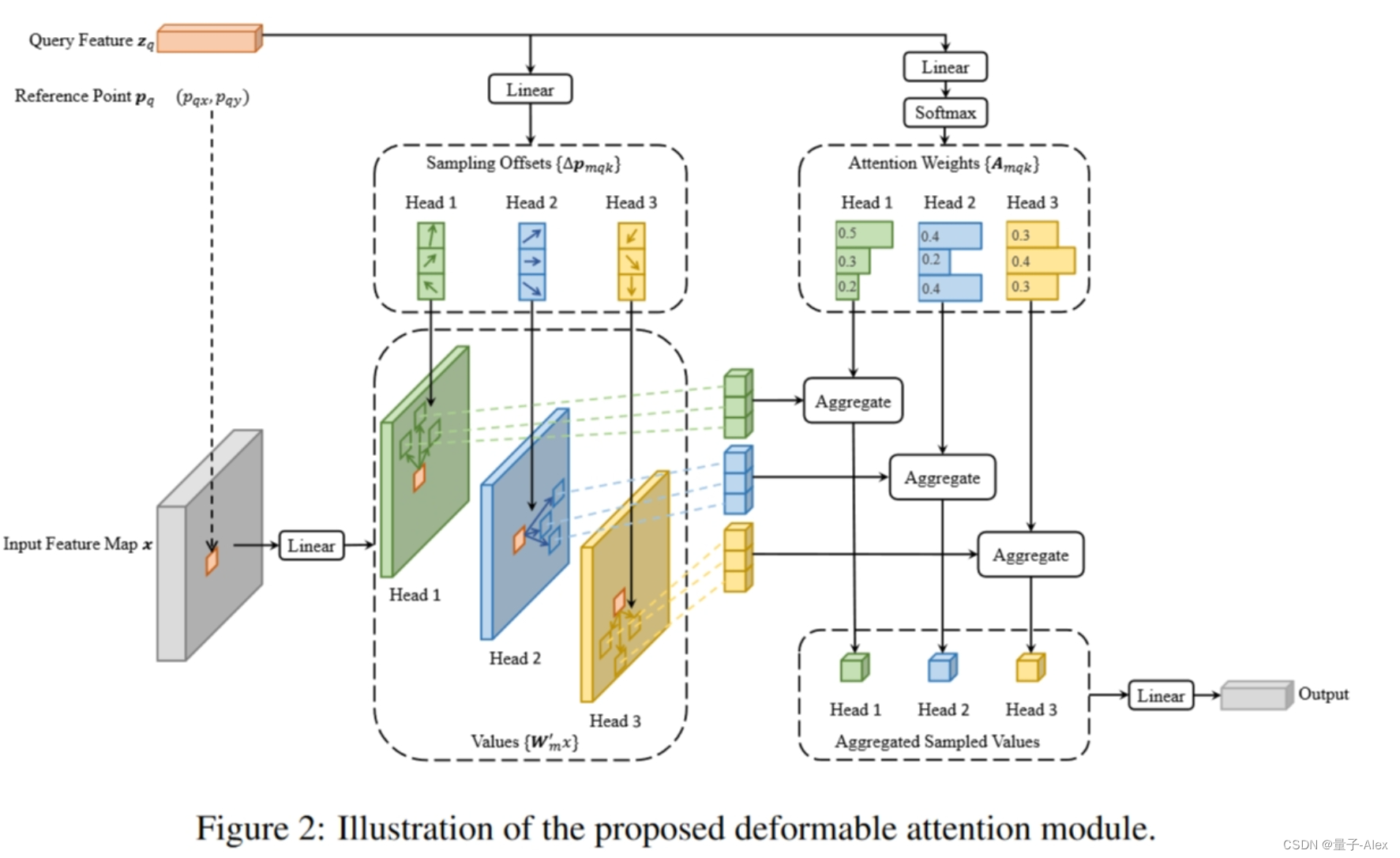

可变形注意力机制

当前的点作为query,只跟周围的4个点作为key,去计算相似度分数。基于当前点的偏移量

这4个点的贡献不相同,

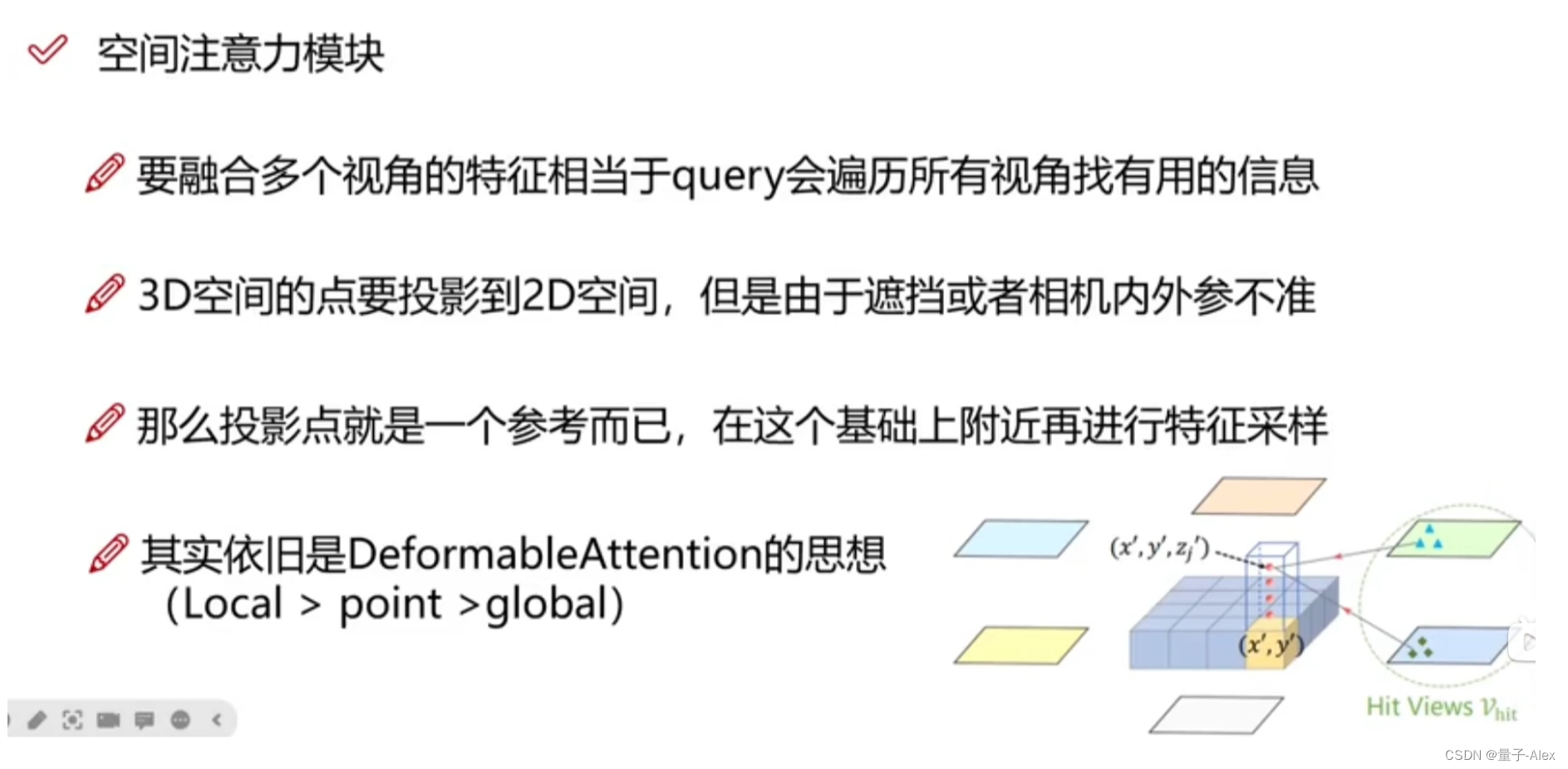

空间注意力机制

映射到特征图,不一定是准确的那个点,得到的平面是一个高度的,一个点对应4个query,每个query对应一个不同的高度。

先做时间注意力,后做空间注意力

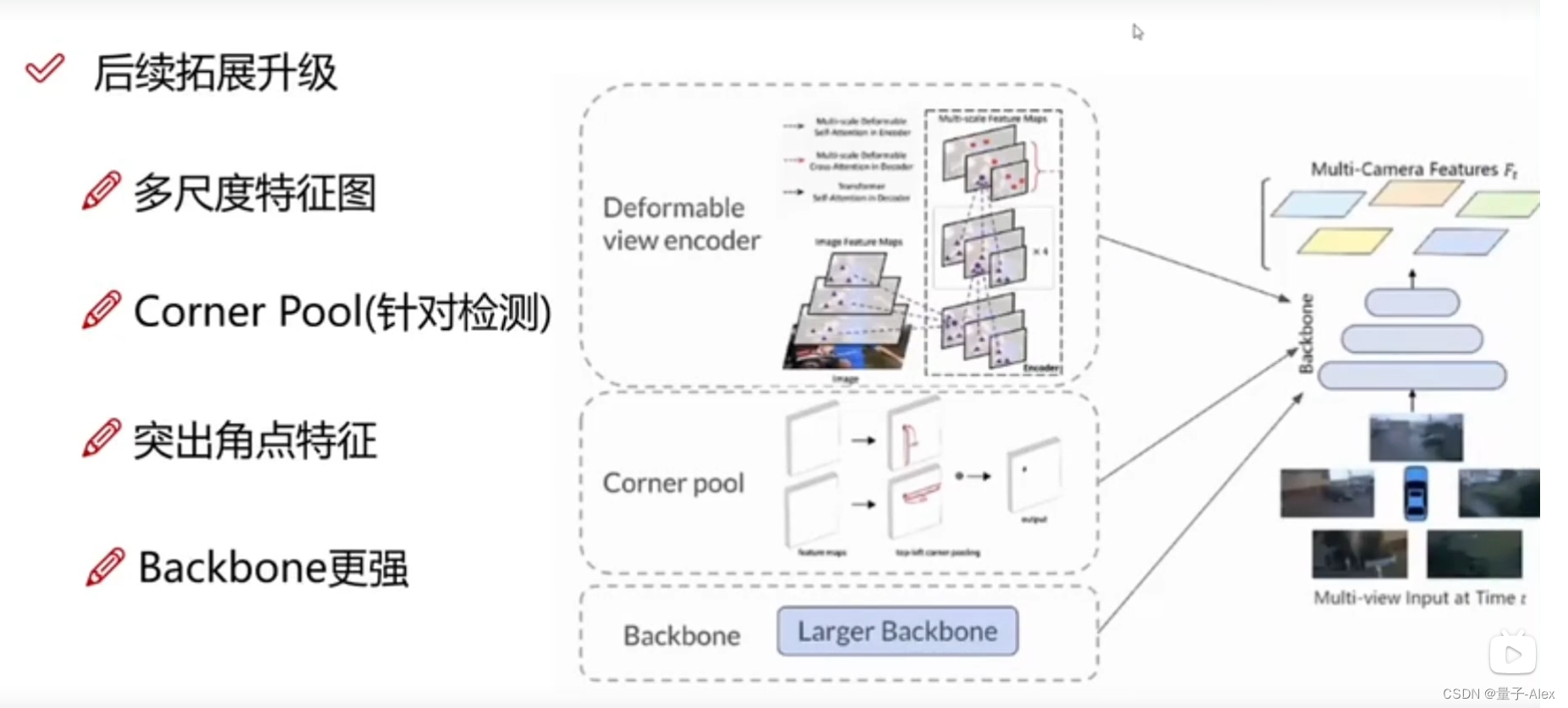

BEVForm++

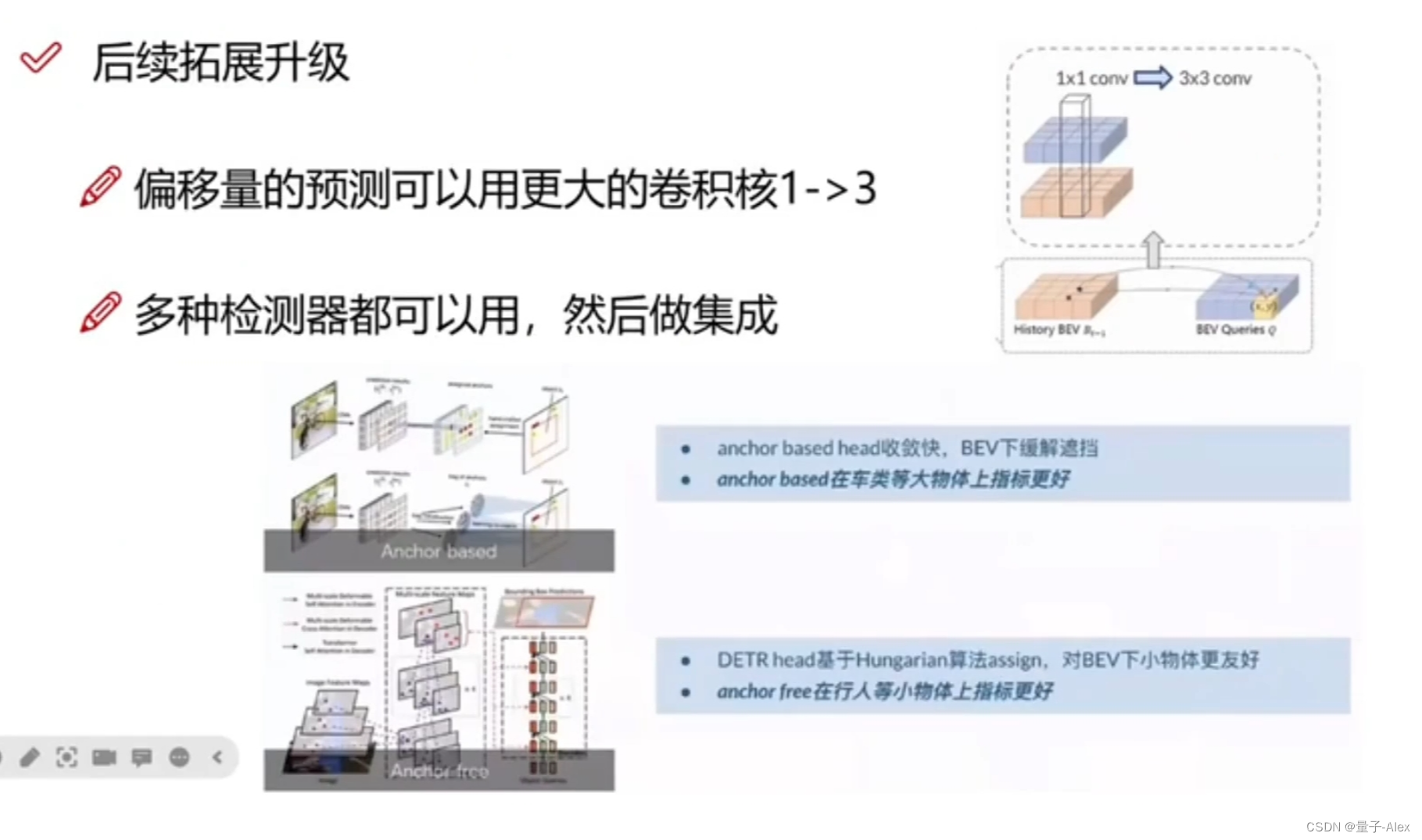

把1x1的卷积核换成3x3的,感受野更大,可以考虑周边的情况,让偏移量的预测更准确

先做时间,如果不做时间注意力,后面就不准确,可以把前面的query作为初始化。

windows跑不了,必须是Linux环境,显存至少12G以上,

)

,你能解释一下JVM的体系结构吗?)

![[职场] 事业单位医疗岗常见的面试题目 #微信#微信#微信](http://pic.xiahunao.cn/[职场] 事业单位医疗岗常见的面试题目 #微信#微信#微信)

--List 列表操作(1))