为什么几乎所有人第一次微调,都会选 LoRA

如果你第一次接触大模型微调,几乎一定是从 LoRA 开始的。

原因也很简单。

网上的教程、博客、开源项目,几乎都会告诉你同一句话:

“别怕,LoRA 很轻量,很安全,很适合新手。”

于是你会看到一种非常普遍的路径:

- 第一次微调 → 直接 LoRA

- 显存不够 → LoRA

- 怕把模型训坏 → LoRA

LoRA 确实解决了很多现实问题,这一点没有任何争议。但问题在于,LoRA 被过度神话了。很多人把它当成了一种“几乎没有代价的微调方式”,仿佛只要挂上 LoRA,就能放心大胆地训练。

而真实工程里,LoRA 带来的,从来不是“没有代价”,而是代价被换了一种形式。

先把话说清楚:LoRA 到底省了什么,又没省什么

在继续之前,有必要先把 LoRA 的“账”算清楚。

LoRA 省掉的,是全参数微调带来的显存和算力压力。

你不需要为整个模型的参数计算梯度,只在少量低秩矩阵上更新,这在工程上确实非常友好。

但 LoRA 没有省掉这些东西:

- 模型原本的能力边界

- 数据分布带来的风险

- 目标定义不清带来的混乱

- 评估不足导致的误判

换句话说,LoRA 只是让“训练这件事”更容易开始,但它并不会让“微调这件事”变得更简单。

第一个常见误解:LoRA 很安全,所以可以大胆试

这是我见过最多、也最危险的一种认知。

很多人会觉得:

“反正 LoRA 不会改原模型参数,训坏了也没关系。”

这句话技术上是对的,工程上是错的。

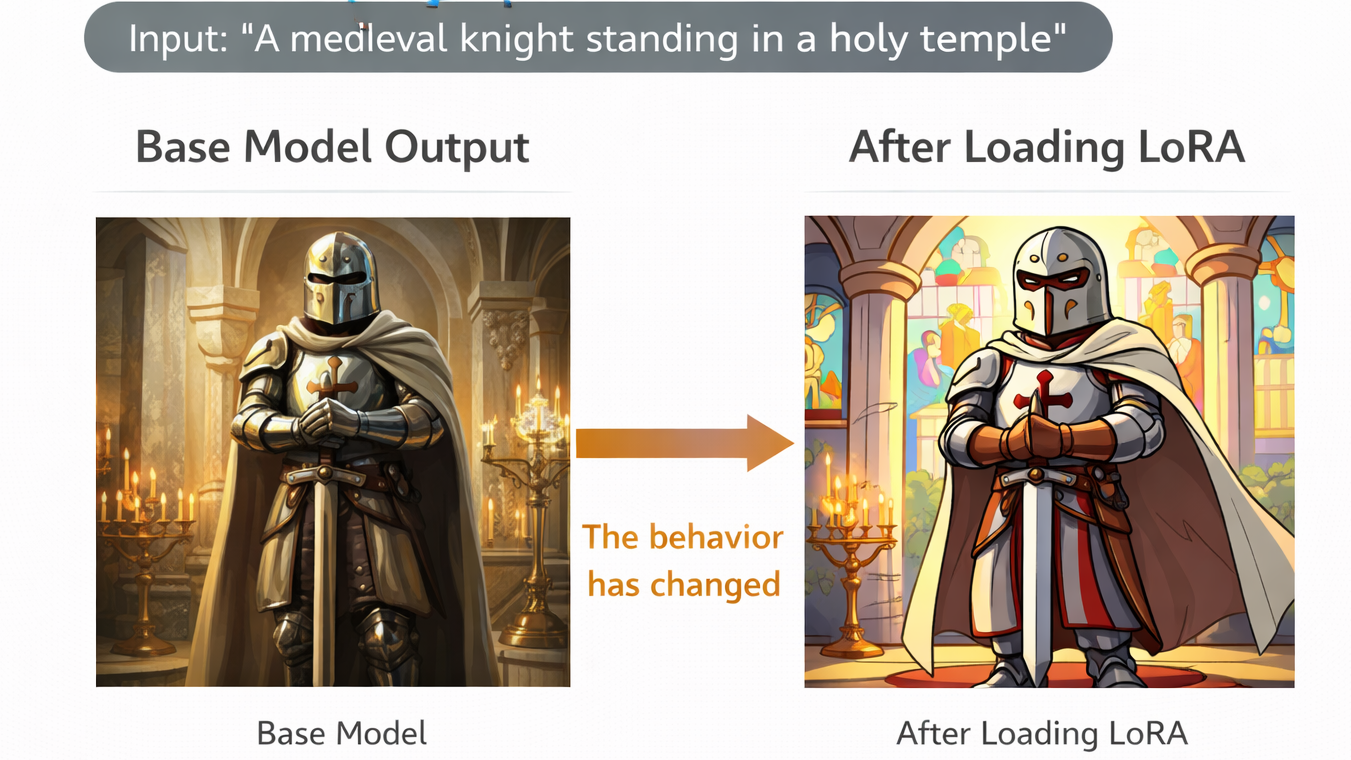

是的,LoRA 不会直接破坏 base model 的权重,但它会改变模型在推理时的行为分布。一旦你在生产环境中加载了 LoRA,它的输出方式、偏好和边界,都会发生变化。

而这些变化,并不会因为“只是 LoRA”而自动变得安全。

加载 LoRA 前后模型行为变化示意图

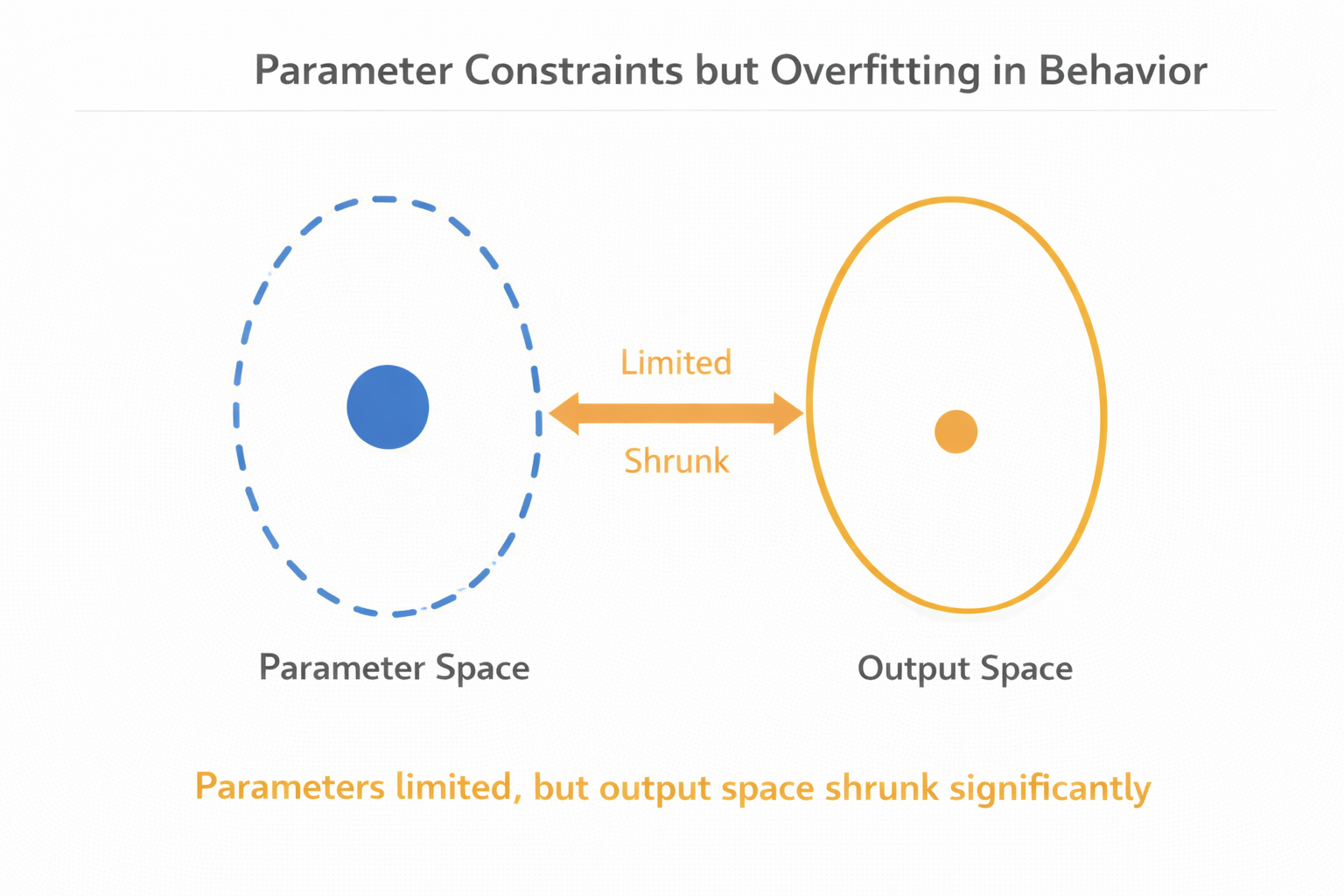

第二个常见误解:LoRA 更不容易过拟合

这是另一个非常流行、但经常被误用的说法。

LoRA 确实限制了参数更新空间,这在一定程度上降低了“参数级过拟合”的风险。但这并不等于:

模型行为层面不会过拟合。

在真实项目中,我见过大量这样的情况:

- LoRA rank 很小

- 训练数据也不多

- loss 看起来很稳定

但模型输出却开始明显模板化,只在特定说法上表现好,一换表达方式就完全不对。

这不是参数维度的问题,而是数据分布 + 目标单一导致的行为过拟合。LoRA 并不能帮你避免这一点。

参数受限但行为过拟合的示意图

LoRA 最容易被忽略的代价:表达能力被“锁死”

这是一个在论文里不太会被强调,但在工程里非常真实的问题。

LoRA 的核心思想,是假设模型的更新可以用低秩表示。这个假设在很多任务上是成立的,但它也天然带来一个限制:

你只能在一个相对狭窄的子空间里调整模型。

这意味着什么?

如果你的任务需要的是:

- 细粒度推理能力提升

- 复杂逻辑结构变化

- 大幅风格重塑

那 LoRA 很可能会显得“使不上劲”。

你会看到一种很典型的现象:

调了很久,模型确实变了一点,但始终差一口气。

不是你没调好,而是 LoRA 本身不适合这个目标。

rank 和 alpha:看起来是参数,其实是能力上限

很多 LoRA 教程里,rank 和 alpha 被当成“调参细节”一笔带过。但在真实工程里,它们几乎决定了 LoRA 的能力上限。

rank 决定的是:

你允许模型在多大的子空间里调整行为。

alpha 决定的是:

这些调整在推理时有多“显眼”。

如果 rank 过小,你可能会发现:

无论你怎么调数据、怎么调训练步数,模型变化都非常有限。

但如果你盲目把 rank 拉大,又会迅速失去 LoRA 原本的工程优势。

不同 rank 下模型变化幅度对比图

为什么 LoRA 特别容易“掩盖问题本身”

这是一个非常微妙、但非常常见的现象。

由于 LoRA 训练成本低、启动快,很多人会在目标还没想清楚时,就反复“试几轮看看”。但这样做,很容易掩盖真正的问题。

比如:

- 问题本来是 prompt 没写清楚

- 问题本来是评估方式不对

- 问题本来是业务目标不明确

但你不断用 LoRA 试,模型每次都会“变一点点”,于是你误以为方向是对的,只是“还差一点”。

结果就是:

你在一个错误的问题定义上,投入了越来越多的训练轮次。

一个现实建议:LoRA 更适合“验证方向”,而不是“终局方案”

这是我自己在项目中逐渐形成的一个判断。

LoRA 最适合的角色,其实是:

低成本验证“这个方向值不值得继续”。

当你还不确定:

- 这个数据有没有用

- 这个目标定义是不是合理

- 模型是否能学到你想要的行为

LoRA 非常合适。

但一旦你确认:

- 这个方向是对的

- 这个能力是核心价值

- 这个行为必须稳定可靠

那你就应该开始认真考虑:

- 是不是要调整策略

- 是不是要换更合适的微调方式

- 是不是要组合使用 SFT / PPO / DPO

在这种“快速验证方向”的阶段,使用 LLaMA-Factory online 先尝试不同 LoRA 配置和数据组合,观察模型行为变化,往往比一开始就重工程投入更高效。

LoRA + 其他微调方式,才是常态而不是例外

在真实工程中,很少有成熟系统是“只靠 LoRA 撑起来的”。

更常见的情况是:

- LoRA + SFT,用来快速塑形

- LoRA + PPO/DPO,用来对齐偏好

- LoRA + RAG,用来弥补知识不足

LoRA 并不是“微调的终点”,而是微调体系里的一个组件。

当你把它当成“银弹”,它就会让你失望;

当你把它当成“工具”,它反而会非常好用。

一个容易被忽略的风险:LoRA 版本管理本身就是工程成本

这是很多团队在规模化使用 LoRA 后,才会意识到的问题。

LoRA 很轻,所以你会很容易产生很多版本:

- 这个业务一个 LoRA

- 那个场景一个 LoRA

- 稍微改点数据就一个新 LoRA

时间一长,你会发现:

- 到底加载哪个 LoRA

- 这些 LoRA 之间是否冲突

- 哪个版本效果更稳定

这些问题,本身就是新的工程复杂度。

总结:LoRA 从来不是“免费午餐”,只是账单不在显卡上

写到这里,其实结论已经很清楚了。

LoRA 确实帮你省下了大量算力和显存,但它并没有帮你省下:

- 目标定义的成本

- 数据理解的成本

- 评估判断的成本

- 工程决策的成本

如果你把 LoRA 当成“几乎没代价的微调”,那你迟早会在别的地方把代价还回去。

真正成熟的用法,是清楚地知道:

我现在用 LoRA,是为了什么,又不指望它解决什么。

LoRA 确实解决了很多现实问题,这一点没有任何争议。但问题在于,LoRA 被过度神话了。很多人把它当成了一种“几乎没有代价的微调方式”,仿佛只要挂上 LoRA,就能放心大胆地训练。而真实工程里,LoRA 带来的,从来不是“没有代价”,而是代价被换了一种形式

LoRA 确实解决了很多现实问题,这一点没有任何争议。但问题在于,LoRA 被过度神话了。很多人把它当成了一种“几乎没有代价的微调方式”,仿佛只要挂上 LoRA,就能放心大胆地训练。而真实工程里,LoRA 带来的,从来不是“没有代价”,而是代价被换了一种形式

)