torch.nn — PyTorch 2.3 documentation

torch.nn - PyTorch中文文档 (pytorch-cn.readthedocs.io)

nn是Neural Network的简称,帮助程序员方便执行如下的与神经网络相关的行为:

(1)创建神经网络

(2)训练神经网络

(3)保存神经网络

(4)恢复神经网络

torch.nn中的函数简介

-

Containers(容器):神经网络的骨架

-

Convolution Layers:卷积层神经网络 torch.nn---Convolution Layers-CSDN博客

-

Pooling layers:池化层

-

Padding Layers:Padding

-

Non-linear Activations:非线性激活

-

Normalization Layers:正则化层

-

Recurrent Layers:循环神经网络层

-

Transformer Layers:

-

Linear Layers:

-

Dropout Layers:

torch.nn中Containers

class torch.nn.Module

所有网络的基类。

你的模型也应该继承这个类。

- Module:对于所有神经网络提供一个基本的骨架,一般定义一个神经网络用如下代码。其中,Model代表模型的名称,nn.Module就是继承了这个类的模板。然后我们先用

__init__初始化,其中super(Model,self).__init__()指的是对父类进行初始化,后面的部分是根据自己构建的神经网络个性化定制的。之后我们使用forword函数对输入数据进行计算,也可以这么理解:对于一个神经网络,首先输入数据-->使用forword函数计算数据-->输出数据,这个过程也叫前向传播。

import torch

from torch import nnclass Mymodule(nn.Module):def __init__(self):super(Mymodule, self).__init__()def forward(self, input):output = input+1 #对输入神经网络的数据+1,然后返回return outputmymodule = Mymodule()

x = torch.tensor(1.0) #输入神经网络的数据

output = mymodule(x)

print(output) #输出神经网络的数据神经网络运行过程

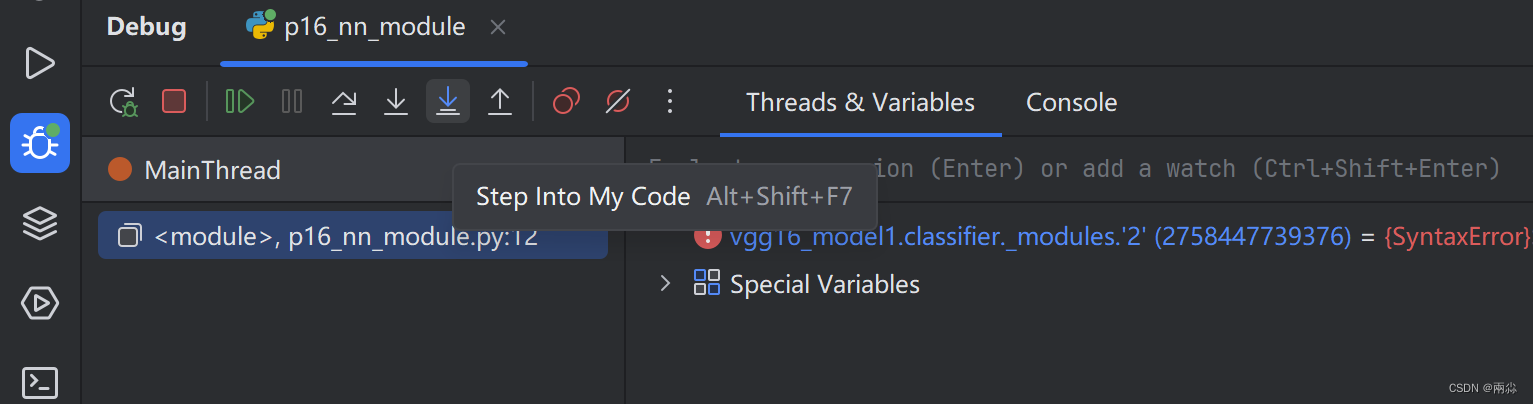

为了更好地说明上面代码的运行过程,把debug打到第14行的mymodule = Mymodule()代码上,并点击Step into My Code:

之后一直点击Step into My Code,就可以看到代码的运行过程如下:

-

在调用

demo=Demo()后,首先使用super().__init__()对nn.Module进行初始化 -

然后设定输入值

x,并使用demo(x)将该值传入到forword函数中 -

forword函数将该值进行加一,并返回output -

最后将返回的output输出

torch.nn.Sequential

Sequential — PyTorch 2.3 documentation

model = nn.Sequential(nn.Conv2d(1,20,5),nn.ReLU(),nn.Conv2d(20,64,5),nn.ReLU())-

在第一个变量名model中,依次执行

nn.Convd2d(1,20,5)、nn.ReLU()、nn.Conv2d(20,64,5)、nn.ReLU()四个函数。这样写起来的好处是使代码更简洁。 -

由此可见,函数nn.Sequential的主要作用为依次执行括号内的函数

。 #微信#其他)

)